DifyからHugging Faceモデルを利用する

Difyは、AIアプリケーションを容易に開発できるプラットフォームとして人気を集めています。コーディングスキルが不要な直感的なインターフェースを備え、ビジネスユーザーからエンジニアまで、幅広い層に利用されています。利用可能なAIモデルはOpenAIをはじめ、Anthropic、Azure OpenAI、Gemini、Google Cloudなど有名どころはもちろん多種多様にサポートしています。利用可能なモデルプロバイダーはここをクリックしてください。

今回は「Hugging Face Model」を使ったところ

- Hosted Inference APIの意味

- Model Name指定の仕方

- API Tokenの権限設定

などが分からなかったので共有いたします。

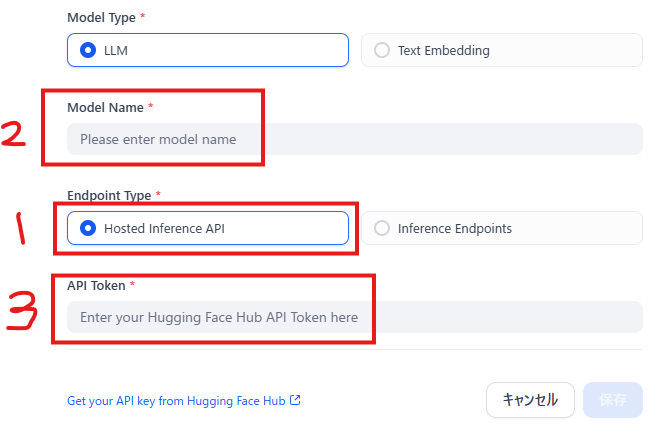

1.Hosted Inference APIの意味

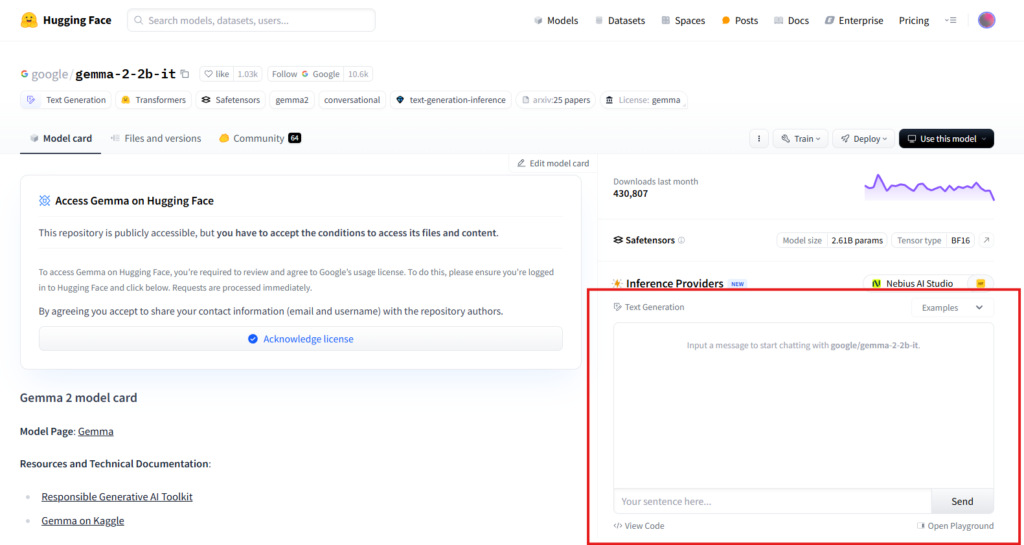

今回の目的は、Hugging Faceに登録されているAIモデルを、下図のようにHugging Faceの画面からではなく、外部のDifyから活用することです。逆に言うと、下図のようにHugging Face画面から操作可能なモデルは「Hosted Inference API」としてDifyから活用できるAIモデルを意味しているようです。

2.Model Name指定の仕方

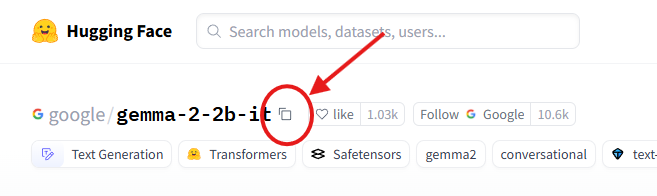

上図のように例えばgoogle/gemma-2-2b-itを利用する場合、単純に「google/gemma-2-2b-it」と書くだけでした。間違いのないようにコピーアイコンを用いると確実でした。

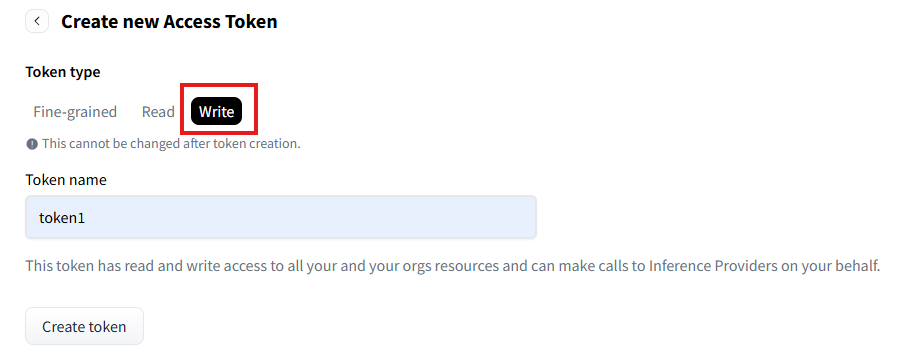

3.API Tokenの権限設定

Hugging Face側でトークン作成時、「Fine-grained」「Read」「Write」の3種類から選択できますが、デフォルトの「Fine-grained」では詳細な設定が必要で、最初はうまく設定できませんでした。結局、「Write」を選択すると、設定項目はなく、トークン名を指定するだけでした。「Write」権限は、おそらく最も強力な権限のようで、Dify側でのモデル設定もうまくいきました。